摘要:算法治理是当前理论研究和实践探索的前沿议题。已有研究视算法为同质化对象,试图总结其一般性发展应用规律以探索普适性治理理论,却忽略了差异多元的算法属性。本文从技术嵌入、价值倾向两个维度提出了理解算法治理属性的新视角,分别聚焦算法技术实现过程中与所处环境的相互影响关系与程度、算法业态应用过程中是否涉及价值目标选择及程度。本文提出匹配不同类型算法治理属性的控制式、合作式、认证式、评估式四种治理模式,并以检查监测、自然搜索排序、犯罪风险评估、个人信用评级四类算法的治理方案为例,证实了算法分类治理框架的合理性和适用性。算法治理属性的二维解构及其算法分类治理理论框架,助益于算法治理实践的改革进程。

关键词:算法治理 人工智能 技术嵌入 价值倾向 分类治理

中图分类号: F11 F49

一、引言

数字技术的泛在应用与风险渐显标志着人类进入技术化社会的新阶段(Ellul, 1964)。当前,技术发展与治理发展之间的速度差异,导致以“政府为主导、命令-控制为特点”的传统监管体系难以回应新阶段的治理需求。纳入多元主体共治并探索数字技术治理理念、结构、机制创新,成为跨学科研究的焦点议题(Mandel, 2009; Kuhlmann et al., 2019)。然而,现有研究将数字技术视为同质化治理对象,试图总结其一般性发展应用规律以探索普适性治理框架的思路,在一定程度上忽略了数字技术内在的多样性和差异性,或将影响相关理论的延伸与发展。作为数字技术的典型代表,算法被视为针对特定问题而形成的数字化解决方案集合(丁晓东,2020)。近年来,由于人工智能技术的发展突破了“波兰尼困境”,算法应用的范围和深度进一步扩大与提升(贾开,2019)。当下研究热点关注于梳理算法应用的一般性逻辑,探索算法治理的普适性框架(张欣,2019;梁正,2020;胡健,2021;Whitford &Anderson, 2021)。技术应用场景的丰富性、人类活动的多样性、针对同一问题可能具有不同解决方法的差异性,都决定了算法作为被治理对象的异质性。从而,将算法视为同质化技术现象的传统技术治理思路难以有效回应根植于算法动态异质性而出现的一系列治理难题。

强调匹配不同算法特征及其治理需求的分类治理框架探索,是算法治理理论创新及实践发展的新思路。算法治理理论的这一理念转变,与近年来政策研究强调区分不同政策的异质属性,匹配以差异化决策机制的理念转变不谋而合(赵静、薛澜,2021)。它们都共同反映了复杂性社会背景下,区分不同议题属性并对其“分而治之”的治理思路。就实践层面而言,算法分类治理的重要性和必要性同样得到了国内外规制主体的承认。尽管在理论和实践层面都得到了承认,但究竟应如何建构算法分类治理的理论框架,并针对不同算法匹配以合意的治理机制,仍然是尚未得到充分讨论的重要理论问题。

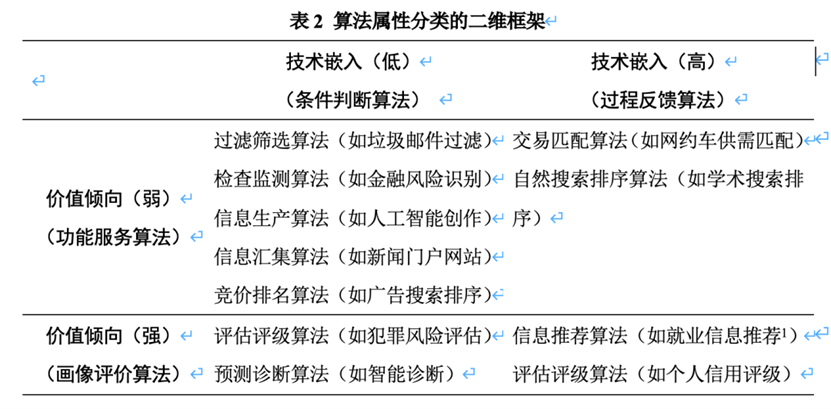

本文试图以匹配治理对象属性与治理机制的分类治理理念为起点,从技术嵌入和价值倾向两个维度提出理解算法分类治理模型的基本框架。作为一类治理要素属性,技术嵌入具体是指算法嵌入社会程度的高低,其主要总结算法的技术实现逻辑。根据是否接受反馈作为判断标准,算法既可以是只依赖设计者决策并因而较少嵌入社会的条件判断模式,也可以是嵌入人类社会并不断调整优化的过程反馈模式。第二类治理要素是表征算法包含目标多寡的价值倾向程度,其总结了算法的业态应用逻辑。根据是否涉及多元目标选择排序的判断标准,算法既可以是为了实现单一确定目标并因而较少体现价值倾向的功能服务模式,也可以是针对多元模糊目标进行选择排序以对特定对象做出价值性判断的画像评价模式。在该框架的学理讨论基础上,本文构建了适应不同种类算法的治理机制,并以检查监测、自然搜索排序、犯罪风险评估、个人信用评级四类算法的治理方案为例,论证分类治理机制的合理性与适用性。

面对第四次工业革命时期日益变化的新经济模式与技术迭代,各国在算法治理实践与政策制定方面亟需有相应的理论指导。尤其是在数字经济蓬勃发展的中国,纷繁复杂的算法应用风险致使各领域的监管实践面临了棘手的治理挑战。习近平总书记在中共中央政治局第三十四次集体学习时指出,“要完善数字经济治理体系”。算法治理作为数字经济治理体系的重要组成部分,其理论创新和实践改革对于推进数字经济高质量发展、实现国家治理现代化具有关键意义。本研究的核心贡献是试图从学理层面推进和发展算法治理理论的创新,以算法作为治理对象的属性异质性为起点,建构算法分类治理的理论框架,既为未来研究奠定基础,也为当前改革提供启示。需要指出的是,分类治理并不意味着“分而治之”,其作为理论框架的提出意在推进算法的整体性治理。正是基于两个维度的类别划分,本文在指出不同算法差异性的同时,也解释了它们之间的内在联系,助益利益相关方在整体上把握不同治理模式的调整或切换,并体现在新兴技术领域被广泛推崇的“敏捷治理”理论的内涵。

二、理论回溯:算法风险与治理机制的多样性

算法发展与应用所引致的社会风险是“倒逼”当前治理机制创新的重要原因。学者们注意到不同算法在差异化场景下应用时出现的多样性风险,并发展出指导实践的治理机制。然而,这些研究重点是聚焦总结算法治理风险的一般性特征(例如动态性、不确定性),致力于提炼普适性的治理框架,从而替代“命令-控制”型的传统技术监管模式。对算法作为被监管对象异质性属性分析的不足是亟需完善的理论缺口。

(1)算法应用风险的多样性

风险社会的研究缘起于人们对建立在科学与理性基础上的现代化进程的反思,如伴随技术革命而出现重大事故的反思,环境污染、食品安全、核污染扩散等(Mythen, 2021)。数字技术革命的兴起同样引发了研究者对与之伴随的社会风险的关注。不同的是,数字技术在不同场景应用的普及性、与人类生产生活紧密关联的嵌入性、对人类社会产生影响的潜在性,都让相关风险具有了新特征。其中,算法风险表现的尤为明显。

早在20世纪末21世纪初,算法发展与应用的社会风险就引起了学者们的关注,彼时焦点主要集中在算法作为社会运行“隐秘”规则的正当性与合理性上。莱辛格在反驳“网络乌托邦主义”空想之后,提出了“代码即法律”的重要论断,并要求国家约束数字平台企业以算法为载体制定网络空间运行规则的权力(Lessig, 2019)。帕斯奎尔更加系统地论述了数字平台通过算法建构的“黑箱社会”的内在机制及其社会风险(Pasquale, 2015)。彼时学者们更多将算法视为商业平台制定的、对用户行为产生影响的网络规则,与之相关的社会风险主要涉及平台作为规则制定者的权力转移以及规则制定过程的程序不透明问题。

随着近年来人工智能技术瓶颈的突破,算法设计突破了“波兰尼困境”的局限,实现了基于大数据的自我生产。算法已经不能被简单视为平台单方面能够决定的网络规则,而是表现为与社会反馈互动的复杂进程,由此引发的治理风险也随之多元化,并具体表现为权力性风险、失控性风险、权利性风险、社会性风险等(Agarwal, 2018)。第一,祖博夫、莫罗佐夫等政治学和法学学者注意到了算法普及应用带来的权力关系转移和变化,数字平台公司在数据规模、技术能力、应用场景等方面的优势可能带来全面监控、硅谷霸权、管理主义等权力性风险(Zuboff, 2019;Morozov, 2019;阳镇、陈劲,2021)。第二,未来生命研究所、电气电子工程师学会等机构关注到了算法的功能性问题,其既体现为超出利益相关方所预设、理解、可控范围且带来负面效果的失控性风险(Future of Life Institute, 2017),也表现为因为缺乏技术标准、质量管控体系而暴露出的功能性不足。第三,基于算法在具体场景下应用所引发社会风险的广泛研究,研究者揭示了算法在针对特定个体或群体时可能出现的歧视、不平等问题,并最终体现为导致特定主体在劳动机会、福利分配等方面权利受损的权利性风险(Floridi et al., 2020)。第四,考虑到算法应用及其影响的潜在性,研究者注意到了在较长时间段内,算法可能对人类社会所秉持的社会价值、公共利益造成的冲击与影响,算法“回音壁”、算法茧房以及算法应用背景下人的自主性降低,都是代表性案例(Flaxman et al., 2016)。

(2)算法治理机制的多样性

算法发展与应用风险的多样性,要求算法治理机制的创新以作为应对。技术革命背景下风险社会的不确定性和动态性是学者们探索技术治理机制的基础。传统的“命令-控制”式技术监管被普遍认为不能适应风险治理环境的变迁,政府单方面“监管模式”转向多元主体共同参与的“治理模式”成为新一代理论的起点。学者们相继提出了规制治理、敏捷治理、实验主义治理、预期式治理、协同治理,试图发展出应用于不同领域的普适性治理框架。

具体而言,“规制治理”试图在市场自发秩序和政府干预之间寻找第三条道路,其在规制实践中引入治理理念,将被规制者的知识和资源纳入制度框架以实现治理目标(Lobel, 2012)。“敏捷治理”理念经由世界经济论坛提出后得到了不同学者的阐发与充实(Mergel et al., 2021),在强调不同主体广泛参与的同时,其更加注重政策工具的快速反应和适应性演化(薛澜、赵静,2019)。“实验主义治理”是基于欧盟治理实践的总结与归纳,关注在持续增长的变动和不确定环境中,通过建立临时性行动框架并在执行效果的评估过程中对行动框架加以深化或修正(Sabel & Zeitlin, 2012)。

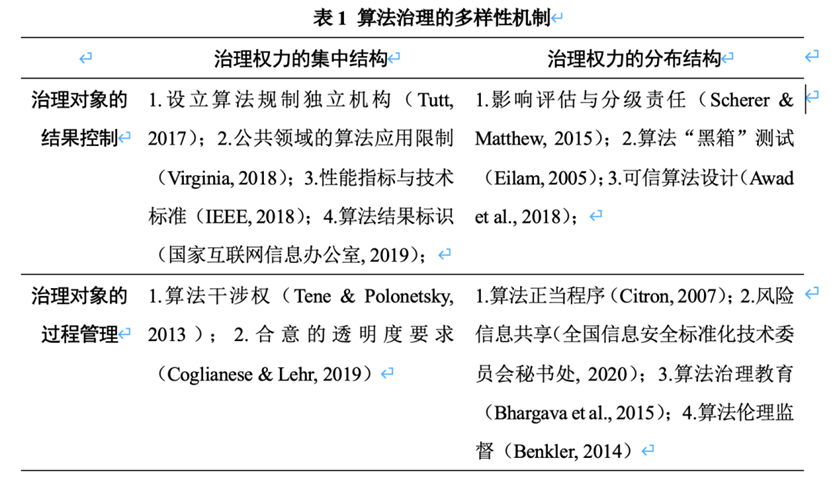

“命令-控制”型监管模式和上述三种代表性新治理理论的关注重点都围绕“治理权力的结构分布”和“治理对象的环节划分”两个维度而展开:一是新治理理论大都要求非政府主体(尤其是被监管对象)参与治理决策的制定和治理规则的调整,以与传统科层制结构下治理权力集中于政府相区别;二是新治理理论关注的竞争、学习、评估、反馈、调整等机制,体现了对于业态发展过程中不同环节可能出现治理风险的关注与应对,与传统监管模式聚焦结果的思路相区别。由此,新兴技术治理模式便大致可从这两个维度加以分类,而算法治理研究与实践提出的诸多改革方案,也事实上可被置于其中并因此体现出治理机制的多样性(如表1所示)。

(3)作为治理对象的异质属性

算法治理机制的多样性提出了两个新的理论问题:不同的算法治理机制应如何与治理问题相匹配,以实现算法治理的目标与绩效?什么因素决定了不同治理机制的差异与选择?已有部分研究关注了算法类型及其治理属性的异质性。例如Latzer等人将算法概括为搜索排序、检查监测、预测诊断、过滤筛选、评分评级、交易匹配、信息汇集、信息推荐、信息生产九种类型,不同类型的算法技术原理和应用逻辑都存在较大差异(Latzer et al., 2016)。Krafft等人基于“委托-代理”结构,根据算法系统设计者/应用者与用户之间信息不对称程度的强弱,区分了决策算法系统的四种类型,并总结了不同类型的治理特征和治理需求(Krafft et al., 2021)。但对算法作为治理对象的异质性关注不足,导致已有研究尚未提炼出涵盖不同算法治理情景的理论框架。

三、“技术嵌入-价值倾向”框架:理解算法治理的机制匹配

(1)算法治理属性的两个维度

图灵奖得主唐纳德-高德纳曾指出,“计算机科学就是算法的科学”。算法概念的完整内涵应从计算机科学领域的探索中得到启示。在计算机科学领域,公理化思想和计算化思想指引了算法的定义与理解。公理化思想继承于古希腊欧几里得流派的西方现代数学传统,其旨在围绕推理论证建立形式化的完备数学体系。在公理化思想的影响下,算法被认为是纯粹形式上的理性存在,并因此披上了客观、中立、可靠、最优的外衣而备受追捧(Goffey,2008)。计算机科学领域对算法的两类经典定义即是公理化思想的具体体现:将算法视为“逻辑+控制”的二元组合(Kowalski, 1979),或者是在有限步骤内按照一定程序完成的计算过程(Gurevich, 2012)。

与公理化思想相比,计算化思想强调从具体问题入手并将数学论证转换成计算形式,其重点在于找到合适的计算方法以求解问题。计算化思想可被视为中国数学传统的沿袭,例如吴文俊院士曾指出,“从问题出发、面向应用的中国传统数学注重求解的计算方法,而西方数学沿袭公理化的思想更注重建立在因果演绎基础上的定理证明”。继承计算化思想,计算机科学领域的算法定义体现三方面内涵:首先,算法不再是公理论证过程中的唯一解或最优解,针对特定问题往往存在不同的计算方法及其组合;再者,算法不再是一个绝对抽象的数学概念,而是根植于问题环境并强调与环境的动态适应性;第三,算法不再是相对于执行过程中其他因素的独立现象,而是需要考虑包括硬件、软件在内的系统概念。上述三点的共性是将算法所处应用环境纳入了考量范畴,而这对揭示算法属性具有重要的意义。

基于两种数学思想的分野,本研究从技术嵌入与价值倾向两个维度对算法内在的治理属性进行解构:从技术实现逻辑角度,算法既可被视为抽象公理模型的界定与演绎,也可被视为根植于应用环境而孕育出的多种计算方法,二者的区别即在于技术嵌入环境的程度的高与低;从应用逻辑角度,算法既可被视为实现既定单一目标而预先确定的方法与过程,也可被视为源于环境复杂性而在不同目标间作出的平衡与选择,二者的区别在于价值倾向的强弱与否。

“技术嵌入”维度(Technology Embedness)

技术嵌入是指算法在技术实现过程中与所处环境的相互影响关系和交互程度。在以机器学习为代表的新一代人工智能技术发展之前,算法的技术参数主要取决于设计者的事前考量,而算法输出则是对输入变量的取值进行判断并根据设计者预先设定的条件得到相应结果。于传统算法而言,技术嵌入仅体现为应用环境通过对输入变量赋值进而对输出结果产生影响,此时算法更多被视为独立于环境的理性模型,按照条件判断的基本思路决定其技术参数与输出结果。相比之下,建立在大数据训练基础上的机器学习算法,其技术参数并不取决于设计者的预先确定,而是在针对大数据进行训练过程中通过自我学习而提炼出规则与特征。伴随着算法的应用,环境数据不断产生、更新并被持续反馈至算法以实现技术参数的动态调整,此时更多遵循“过程反馈”原则。由此,条件判断和过程反馈构成了体现算法技术嵌入程度强弱的两个代表性类型。前者的技术嵌入程度低,其作为治理对象的风险也较为确定;后者的技术嵌入程度高,其往往也体现出较为复杂和不确定的治理风险。

“价值倾向”维度(Value Orientation)

对相同算法而言,其被应用于不同场景时也将产生差异化的治理需求。价值倾向维度关注算法应用过程是否(或在多大程度上)涉及价值目标的选择问题。算法应用过程的价值倾向性将影响算法的角色定位,并决定所涉治理议题的范围和深度。算法的价值倾向性越小,其越多以功能服务模式体现为满足单一确定目标的中立性工具职能,并因此只涉及线性且结果导向的治理要求;算法价值倾向性越大,其越多以画像评价模式体现为针对不同目标进行选择排序以作出价值性评估,由此算法也成为影响个体权利或公共利益的行为主体。

基于算法技术实现和算法应用业态维度,本文分解了算法治理属性,建构了“技术嵌入-价值倾向”的二维框架,厘清了各类算法间的差异与联系。表2列举了部分较为普及应用的算法。

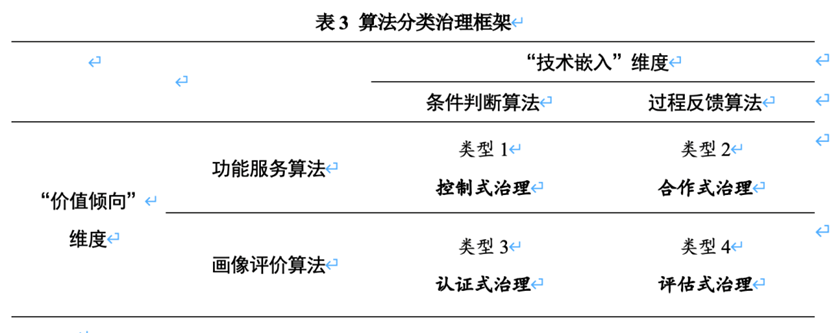

(2)算法分类治理机制的探索

算法分类治理理论建构目的在于探索不同类型的算法应匹配以何种治理机制才能实现较优的治理绩效。依据“技术嵌入-价值倾向”的治理属性二分框架,本文适配了控制式治理、合作式治理、认证式治理、评估式治理等四种类型的治理机制,用以分别说明四种算法类型的治理需求(如表3所示)。

控制式治理

作为一类治理对象,类型1算法的特征是技术嵌入和价值倾向程度都较低,其在技术实现逻辑方面更多取决于设计者而与应用环境相对独立,在业态应用逻辑方面则更多体现为工具职能且旨在完成功能服务。此种类型的算法,导致治理风险的原因较为明确,其大致可归咎于算法设计者的质量责任或部署应用者的使用责任,因此适宜以控制式治理加以应对。控制式治理是治理权力集中且聚焦治理对象结果控制的治理机制组合,其类似于传统的“命令-控制”监管模式。此时,政府是治理权力的所有者,其针对算法所要达成的功能性目标事先确定好标准或规范,并监督算法发展及应用的结果是否满足此标准或规范的要求,从而根据确定的责任分配原则对算法研发者或部署应用者实施惩罚。

合作式治理

类型2算法的特征是技术嵌入度较高而价值倾向度较低,其在技术实现逻辑方面更多嵌入应用环境并因此可能体现较为复杂的风险因果联系,在业态应用逻辑方面仍然体现为工具职能并旨在完成功能服务。针对此种类型算法,算法的技术实现不仅决定于设计者,同时还受到应用环境反馈的动态影响,这也使得导致算法应用风险的原因难以明确界定,因而要求治理权力分散化、多元化以调动不同治理主体的比较优势;同时,算法治理风险仍然主要体现为算法输出结果不能满足功能性目标的工具性风险,算法设计、研发、应用的过程并非导致风险的关键原因。由此,以治理权力分散且聚焦治理对象结果控制的合作式治理便成为与该类型算法相匹配的治理机制。

认证式治理

类型3算法的特征是技术嵌入度较低而价值倾向度较高,前者代表着算法技术实现更多取决于设计者而与应用环境相对独立,后者意味着算法应用的重心是对不同目标进行选择排序以作出价值性评估。针对此类型算法,导致治理风险的原因往往源自设计者对不同目标进行价值排序时所引发的质疑,这又具体包括程序上的不透明以及实质上的不合理两个方面。与之匹配的治理机制是认证式治理,其主要强调治理权力的集中并聚焦算法设计及应用过程的监管。一方面,算法风险集中于设计者的技术特征,并不要求多元主体的共同参与,而更强调技术官僚(例如独立规制机构)集聚治理权力并通过事前审核认证的方式,控制风险的产生与扩散;另一方面,无论是程序透明要求还是实质合理要求,都不仅仅停留于针对算法结果的监管,而同时要求对算法研发、部署、应用等不同环节是否侵害个人权利或公共安全作出裁定。

评估式治理

类型4算法的特征是技术嵌入度和价值倾向度都较高,这是最为复杂的算法类型,因其既意味着算法的技术实现过程高度嵌入社会环境,也意味着算法的应用重心在于对不同目标作出价值性选择与权衡。对于此类算法而言,社会风险往往缘于算法与环境的互动过程,且其作为行为主体影响社会权利关系或权力结构的特征,也使得与之相关的治理议题广泛而复杂。面对此种挑战,评估式治理可能是最为匹配的治理机制。评估式治理是分散权力结构与过程导向的组合,其核心特征是在算法研发、部署、应用等不同环节纳入利益相关方,基于风险管理的原则,通过动态评估风险的紧迫性、严重性以调动各方治理能力和优势。相比于前三种治理机制,评估式治理涉及的治理主体、覆盖的治理环节都最多。

四、算法分类治理比较案例分析

为检验算法分类治理机制的合理性与适用性,研究选择以检查监测算法、自然搜索排序算法、犯罪风险评估算法、个人信用评级算法的现有治理机制为例,分析不同算法的属性异质性,并结合现有治理方案解释其如何体现了上述四种治理模式的规律与特点。这四类算法是人工智能领域应用相对广泛、发展相对成熟的主流算法,可以让研究有足够长时间观察算法属性,并清晰比较各国治理实践。

(1)检查监测算法

作为算法应用的基本类型之一,检查监测算法通过监控特定对象的行为数据以识别其常态特征或判断其异常变化,进而为自动或人为决策提供依据。检查监测算法既可能独立应用,也可能作为推荐算法、预测算法的基础或前提,其典型应用场景包括产品质量监督、信用卡欺诈识别、网络攻击识别、身份认证等。就技术实现而言,检查监测算法主要依赖预先设定的判定条件以识别对象特征或异常变化。就应用业态而言,检查监测算法并未对被监控对象作出画像评价,而更多以对象特征或异常变化作为输出结果以提供辅助决策的功能服务。由此,基于本文提出的算法分类治理体系,检查监测算法属于类型1,并因此适用于控制式治理模式。

梳理实然层面的相关研究与实践,检查监测算法的治理风险主要可被概括为以下两点:因过度收集数据而带来的隐私侵害风险,以及因算法功能缺陷而导致的过度识别或识别不足问题。隐私侵害可被视为算法难以在不收集个人信息的前提下实现检查监测目标,而过度识别或识别不足则反映了算法识别的不精准问题,它们都源于算法功能不完善而导致的负面结果。在此基础上,与之匹配的治理措施主要体现了控制式治理的特点,并集中体现为通过技术标准界定算法输出结果所需达到的质量要求等方面。例如国家市场监督管理总局、国家标准化管理委员会在2020年5月发布的《远程人脸识别系统技术要求》即主要针对将人脸识别算法作为身份鉴别功能的信息系统提出了技术标准要求,相关规范主要集中在算法输出结果的功能指标方面,弱化乃至忽略了算法实现过程方面的约束性要求。

(2)自然搜索排序算法

搜索排序算法的技术实现逻辑是基于用户输入关键词,按照竞价排名或者自然搜索规则以先后顺序呈现出不同结果。竞价排名是指被搜索结果通过竞争出价的方式,获取搜索结果页面的位置排序,出价越高则排名越靠前;自然搜索则是通过记录用户点击结果并不断反馈、优化搜索结果的过程,其旨在发现能够最能体现用户兴趣的搜索内容。不难看出,竞价排名更多体现了条件判断的特征,而过程反馈则是自然搜索的主要机制。就应用业态而言,尽管按照何种原则进行排序仍然体现了不同目标之间的竞争与权衡,但搜索排序算法的重点是实现降低信息过载的功能服务,尤其是其不涉及基于特定个体/群体属性的画像评价,因而其价值倾向程度并不强。由此,基于本文提出的算法分类治理模型,竞价排名算法属于类型1算法,而自然搜索排序算法属于类型2算法,本小节更多关注后者。

就实然层面而言,自然搜索排序算法的治理风险主要体现为搜索结果的算法偏见或歧视问题。例如2013年针对谷歌的研究表明(Sweeney, 2013),搜索黑人名字时,排在前面的搜索结果会更多与犯罪记录联系在一起,而搜索白人名字时则不会出现这种情况。造成系统性偏差的原因,并非源于谷歌程序员主观性地加入了种族因素,而是用户在搜索黑人名字时更想了解其是否有犯罪记录,因此有更大概率点击相关内容,从而导致算法在持久的用户结果反馈过程中将犯罪记录内容排在了前面。基于算法分类治理模型,与之匹配的治理模式应为合作式治理,而现有的政策实践也体现了这一特点。当前针对自然搜索排序算法的治理措施主要集中于两点:搜索结果的明显标识以及算法伦理的自我规制。前者要求搜索引擎对竞价排名搜索排序算法的结果做特别说明,以与自然搜索排序算法相区分;后者更多强调通过伦理原则的方式调动多元主体参与协同共治,以推动风险识别、沟通、处理等各个环节的自规制进程。上述两方面分别对应结果控制和分布式权力结构的合作式治理模式特征。

(3)犯罪风险评估算法

犯罪风险评估算法是智慧司法领域的典型应用,其基本功能是对罪犯假释后的再犯风险进行评估以辅助法官作出假释决策,其旨在提升司法效率并降低司法决策过程的人为影响,以维持司法决策的一致性和稳定性(Danziger et al., 2011)。就技术实现而言,犯罪风险评估算法往往通过问卷形式询问罪犯的犯罪历史、生存环境及其反思态度,并根据罪犯的回答给出再犯风险分数,条件判断由此成为实现该类型算法的主要机制,而画像评价则成为其主要应用方式。根据算法分类治理框架,犯罪风险评估算法属于类型3,认证式治理应成为与之匹配的治理模式。

在实然层面,已有研究对于犯罪风险评估算法应用风险的分析,主要聚焦算法歧视问题,即算法是否会对特定人群产生系统性偏差从而侵害其基本权利。例如学者和社会组织批评美国司法环境下广为应用的COMPAS算法。该算法被发现对于事实上不会再累犯的罪犯,黑人犯罪风险的评估会系统性的高于白人。也有研究发现对于事实上会累犯的罪犯,算法对其犯罪风险的评估并不会因肤色的不同而呈现系统差异,也即算法并没有产生歧视问题。导致分析结论冲突的原因在于算法公平性的内涵界定存在差异,即算法优化目标往往在提升“真阳性(True Positives)”和降低“假阳性(False Positives)”之间徘徊,这二者往往呈现此消彼长的负相关关系。由此,犯罪风险评估算法的应用风险更多体现了如何选择算法优化目标(也即选择何种公平性)的价值性风险,与之匹配的治理应对自然需要考虑算法目标的设定过程,而不能仅仅聚焦结果。正因为此,各国大都针对犯罪风险评估算法应用提出了过程性要求,即需要算法研发者或应用者对算法决策过程作出解释。同时,考虑到犯罪风险评估算法的决策结果将影响到被评估者的人身基本权利,为确保算法风险能够得到有效控制,此领域往往依赖技术官僚。后者在此过程中集聚了治理权力,既推动形成过程监管的相关标准(例如算法可解释性的界定),也有助于落实违规惩戒和实施救济。

(4)个人信用评级算法

个人信用评级是金融市场的基本工具之一,基于借贷人的历史借贷数据对其违约风险进行评分,从而辅助贷款人的借贷决策。伴随大数据和人工智能技术的快速发展,个人信用评级算法开始普及应用。一是丰富了评级数据的来源和种类,包括个人履历、社交网络、消费行为在内的诸多数据被纳入评估范畴;二是扩大了评级应用范围,从借贷决策延伸至消费金融、租赁服务等各个领域。就技术实现而言,尽管传统方法主要基于被评估人的历史数据作出条件判断,但当前大数据环境下互联网平台广泛采用的个人信用评级算法越来越多地挖掘利用了个人行为数据的即时反馈,以实现更为精准和及时的评估预测。考虑到算法应用目的是对个体信用及违约风险作出评估,画像评价而非功能服务成为主要应用特征。根据本文提出的分类治理框架,个人信用评级算法属于类型4,评估式治理成为与之匹配的治理模式。

实然层面围绕个人信用评级算法应用风险的讨论主要集中在三点:算法误用或滥用而导致用户基本权利侵害、基于个人身份属性而影响评级的算法歧视问题,以及因算法自动决策而导致的救济渠道缺失。考虑到个人信用评级算法往往受到商业秘密的保护而难以被公众所知悉,上述三类问题的风险多需要较长时间才能体现出来。算法误用或滥用、算法歧视以及救济渠道缺失都并非源于算法功能性缺陷,而应被视为围绕如何设计评级算法、如何应用评级算法等价值性问题的争端,背后表现为个人信用评级算法的价值性风险。由此,评估式治理应成为针对该议题的匹配治理模式。已有法规大都要求给予被评估者质疑评估算法结果、了解评估算法决策过程的权利,例如2003年修订的美国《公平与精准信用交易法案》即做出了类似规定,过程治理特征可见一斑。相关领域学者提出应在信级评分领域发展技术正当程序要求,也秉承了过程治理的思路(Citron, 2007)。赋予被评估者知情权利、正当程序要求中纳入多方监督,都是将利益相关方纳入治理权力结构的分布式思路体现。

五、结论与讨论

数字技术的普及应用正在对人类社会产生根本性影响,这既体现为人类生产生活方法论、行为方式、组织形态等不同维度的变革,更体现为不同领域治理风险的涌现(孟天广,2018)。如何推进治理创新以应对数字化转型进程的机遇与挑战,已经上升为国家治理体系和治理能力现代化建设的重要命题(鲍静、贾开,2019)。作为数字规则体系的重要组成部分,算法治理将成为我国未来一段时间内的制度建设重心。

在新一代人工智能技术创新推动下,算法发展应用所体现出的独特属性,使之不同于数据治理、平台治理等既有议题的讨论,而具有其内在的治理规律与治理需求(肖红军、李平,2019;孙晋,2021)。相比于已有研究和实践试图建构一般性、普适性算法治理框架的努力,算法分类治理则提出了不同的理论视角与改革思路。基于技术嵌入与价值倾向两个维度,本文总结并细化了算法属性分类的基本框架,进而针对不同算法提出了相匹配的治理机制。在研究贡献方面,算法分类治理理论模型弥补了已有研究忽略算法作为治理对象的属性异质性的理论缺口,发展并细化了针对新兴技术和产业的治理模式探讨(Krafft et al., 2021)。同时,研究也填补了治理模式理论创新和监管实践探索之间的逻辑断点,为利益相关方在算法治理领域制定具体政策提供了学理基础,避免在问题聚焦、目标定位、工具选择等方面出现偏差。

值得注意的是,算法本身的技术迭代性及其应用的宽泛性,使得任何提前确定的治理模式都可能面临不确定性的挑战,以及难以覆盖所有治理风险的困境。针对于此,本文做出了如下解释:一是本文对于算法技术的分类是建立在计算机科学思想分野(公理化思想和计算化思想)的基础上,科学思想的稳定性有助于避免因具体技术的动态变化而带来的不确定性。二是算法分类治理框架的理论定位并非要取代已有治理理论或实践,而是作为后者的补充与完善,以共同应对动态变化的、不确定的算法治理风险。不同于已有理论指出了算法治理的基本原则、不同治理主体间的相互关系,本文的算法分类治理框架目的是为在何种条件下应该采用何种治理模式做出指引。当治理环境确定时,算法分类治理框架有助于我们选择合意的算法治理模式;当环境条件发生变化时,在该治理框架下不同治理模式之间的调整或切换也体现了敏捷治理的理论内涵与要求。这两部分都共同构成了算法治理的整体性理论体系。

算法分类治理理论框架对于算法整体性治理的贡献还在于其能够在一般意义上为算法应用划定边界。两个维度指出算法并不仅仅扮演“工具”作用,其同样可能深度嵌入社会进程并扮演价值选择或判断的“主体”作用。相比于前者,后者的治理影响将更为复杂而严重,并对既有技术治理体系提出了更大的挑战。特别对于技术嵌入度高、价值倾向强的算法类型,我们往往需要对其赋予更多的治理关注。评估式治理尽管致力于覆盖算法开发应用的全生命周期,但这一目标在算法技术复杂性和算法应用复杂性的双重挑战下并不一定能完全实现。此时,暂时性的限制乃至禁止此类算法的应用,同样是利益相关方需要考虑的备选方案。本文框架也有助于为禁止使用或高风险算法的界定提供理论解释。

但即使如此,我们依然要重视算法时代技术和业态的创新速度可能超过治理体系完善速度的这一挑战。算法分类治理框架的演化发展应是未来研究与实践的关注重点,典型的研究问题例如不同政治经济环境下算法分类治理框架的调适,数字技术创新导致算法技术实现逻辑演化过程中的算法分类治理框架变迁等。与此同时,面对数字化转型进程的深入,无论理论如何发展完善,政策实践者算法治理意识的树立和算法治理能力的提升更是当务之急。只有充分理解不同算法应用带来的各类风险,具备识别算法及其风险特征的治理能力,才可能科学地选择合意的治理模式。在此进程中,政府不一定是所有算法治理模式的主导者,利益相关方的合作治理仍然是实现治理目标的必要前提。

参考文献:

鲍静、贾开,2019:“数字治理体系和治理能力现代化研究:原则、框架与要素”,《政治学研究》,2019,3:23-32+125-126。

丁晓东,2020:“论算法的法律规制”,《中国社会科学》,2020,12:138-159+203。

高奇琦,2020:“智能革命与国家治理现代化初探”,《中国社会科学》,2020,7:81-102+205-206。

国家互联网信息办公室,2019:“数据安全管理办法(征求意见稿)”,2019。

胡健,2021:“算法治理及其伦理”,《行政论坛》,2021,4:41-49。

贾开,2019:“人工智能与算法治理研究”,《中国行政管理》,2019,1:17-22。

梁正,2020:“算法治理的基本路径与核心理念”,《国家治理》,2020,36:40-42。

孟天广,2018:“政治科学视角下的大数据方法与因果推论”,《政治学研究》,2018,3: 29-38+126。

孙晋,2021:“数字平台的反垄断监管”,《中国社会科学》,2021,5: 101-127+206-207。

国信息安全标准化技术委员会秘书处,2020:“网络安全标准实践指南—人工智能伦理安全风险防范指引”,2020。

肖红军、李平,2019:“平台型企业社会责任的生态化治理”,《管理世界》,2019,4:120-144+196。

薛澜、赵静,2019:“走向敏捷治理:新兴产业发展与监管模式探究”,《中国行政管理》,2019,8:28-34。

阳镇、陈劲,2021:“数智化时代下的算法治理——基于企业社会责任治理的重新审视”,《经济社会体制比较》,2021,2:12-21。

赵静,薛澜,2021:“探索政策机制的类型匹配与运用”,《中国社会科学》,2021,10:39-60+205。

张欣,2019:“从算法危机到算法信任:算法治理的多元方案和本土化路径”,《华东政法大学学报》,2019,22(06):17-30。

Awad, E., Dsouza, S., Kim, R., Schulz, J., Henrich, J., Shariff, A. and Rahwan, I., 2018. “The Moral Machine Experiment.” Nature. 563(7729): 59-64.

Agarwal, P. K., 2018. “Public Administration Challenges in the World of AI and Bots.” Public Administration Review.78(6): 917-921.

Benkler, Y., 2014. “A Public Accountability Defense for National Security Leakers and Whistleblowers.” Harv. L. & Pol'y Rev.281.

Bhargava, R., Deahl, E., Letouze, E., Noonan, A., Sangokoya, D. and Shoup, N., 2015. “Beyond Data Literacy: Reinventing Community Engagement and Empowerment in the Age of Data.” Data-Pop Alliance White Paper Series.

Citron, D. K., 2007. “Technological due process.” Washington University Law Review.85(2): 1249 -1313.

Coglianese, C. and Lehr, D., 2019. “Transparency and Algorithmic Governance.” Administrative Law Review. 71(1): 353-390.

Cohen, J. E., 2019. Between Truth and Power. Oxford: Oxford University Press.

Danziger, S., Levav, J. and Avnaim-Pesso, L., 2011. “Extraneous Factors in Judicial Decisions.” Proceedings of the National Academy of Sciences.108(17): 6889-6892.

Eilam, E., 2005. Reversing: Secrets of Reverse Engineering. Boulevard: Wiley.

Ellul, J., 1964. The Technological Society. Translated by J. Wikinson. New York: Vintage Books.

Floridi, L., Cowls, J., King, T. C. and Taddeo, M., 2020. “How to Design AI for Social Good: Seven Essential Factors.” Science and Engineering Ethics. 26(3): 1771-1796.

Future of Life Institute., 2017. Asilomar AI Princples. Retrieved from https://futureoflife.org/ai-principles/ .

Flaxman, S., Goel, S. and Rao, J. M., 2016. “Filter bubbles, echo chambers, and online news consumption.” Public Opinion Quarterly. 80(S1): 298-320.

Goffey, A., 2008. “Algorithm.” In Fuller, M., eds: Software studies:A lexicon. Cambridge: MIT Press.

Gurevich, Y., 2012. “What Is an Algorithm?”, in Bieliková M., Friedrich G., Gottlob G., Katzenbeisser S., Turán G., eds: SOFSEM 2012: Theory and Practice of Computer Science. Berlin: Springer.

IEEE., 2018. IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems.

Krafft, T. D., Zweig, K. A. and König, P. D., 2022. “How to regulate algorithmic decision‐making: A framework of regulatory requirements for different applications.” Regulation & Governance.2022(16): 119-136.

Kowalski, R., 1979. “Algorithm = Logic + Control.” Communications of the ACM. 22(7): 424-36.

Kuhlmann S, Stegmaier P, Konrad K., 2019. “The Tentative Governance of Emerging Science and Technology: A Conceptual Introduction.” Research Policy.48(5): 1091-1097.

Latzer, M., Hollnbuchner, K., Just, N. and Saurwein, F., 2016.“The Economics of Algorithmic Selection on the Internet.” in Bauer, M. and Latzer, M., eds: Handbook on the Economics of the Internet, Zurich: Edward Elgar Publishing.

Lessig, L., 2009. Code: And Other Laws of Cyberspace. Basic Books.

Lobel, O., 2012. “New Governance As Regulatory Governance.” in David, Levi-Faur., eds: The Oxford Handbook of Governance. Oxford: Oxford University Press.

Mandel, G. N., 2009. “Regulating Emerging Technologies.” Law, Innovation, and Technology.1(1): 75-92.

Mergel, I., Ganapati, S., and Whitford, A. B., 2021.“Agile: A New Way of Governing.” Public Administration Review.81(1): 161-165.

Morozov, E., 2019. “Digital socialism? The calculation debate in the age of big data.” New Left Review.116: 33-67.

Mythen, G., 2021. “The critical theory of world risk society: a retrospective analysis.” Risk Analysis. 41(3): 533-543.

Newman, A, 2015. “European Data Privacy Regulation on a Global Stage: Export or Experimentalism?” in Jonathan, Z., eds: Extending Experimentalist Governance? The European Union and Transnational Regulation. Oxford: Oxford University Press.

Pasquale, F., 2015. The Black Box Society. Boston: Harvard University Press.

Sabel, C. F. and Zeitlin, J., 2012. “Experimentalist governance.” in David, Levi-Faur., eds: The Oxford Handbook of Governance. Oxford: Oxford University Press.

Scherer, M. U., 2015. “Regulating Artificial Intelligence Systems: Risks, Challenges, Competencies, and Strategies.” Harvard Journal of Law & Technology.29(2): 345-400.

Sweeney, L., 2013.“Discrimination in Online Ad Delivery.” Communications of the ACM. 56(5): 45-54.

Tene, O. and Polonetsky.J., 2013.“Big Data for All: Privacy and User Control in the Age of Analytics.”11 Northwestern Journal of Technology and Intellectual Property.11(5): 239-273.

Tutt, A., 2017.“An FDA for Algorithms.” Adminstrative Law Review. 69(1): 83-123.

Virginia, E., 2018. Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor. New York: St. Martin’s Press.

Whitford, A. B. and Anderson, D., 2021. “Governance landscapes for emerging technologies: The case of cryptocurrencies.” Regulation & Governance.15: 1053-1070.

Zuboff, S., 2019. The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power. New York: Public Affairs.

来源:《经济社会体制比较》2023年第4期